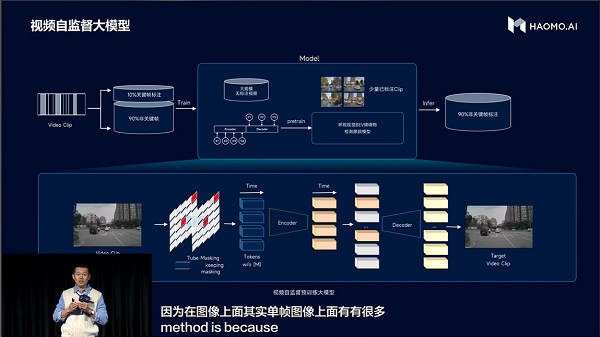

首先,视频自监督大模型,让毫末4D Clip标注实现100%自动化,人工标注成本降低98%。为了更低成本、更高效获取更多高价值数据,需要解决从离散帧自动化扩充到Clips形态的问题。毫末首先利用海量videoClip,通过视频自监督方式,预训练出一个大模型,用少量人工标注好的Clip数据进行Finetune(微调),训练检测跟踪模型,使得模型具备自动标注的能力;然后,将已经标注好的千万级单帧数据所对应的原始视频提取出来组织成Clip,其中10%是标注帧,90%是未标注帧,再将这些Clip输入到模型,完成对90%未标注帧的自动标注,进而实现所有单帧标注向Clip标注的100%的自动转化,同时降低98%的Clip标注成本。毫末视频自监督大模型的泛化性效果极佳,即使是在一些非常困难的场景,例如严重遮挡的骑行者,远处的小目标,恶劣的天气和光照,都能准确地完成自动标注。

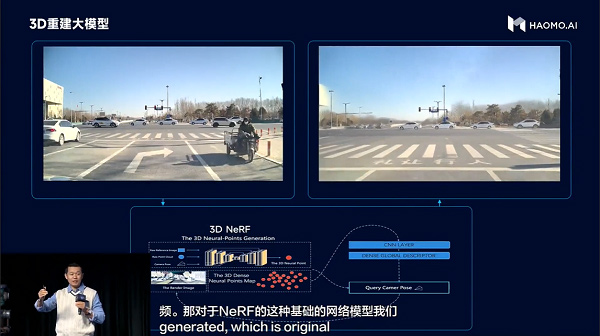

其次,3D重建大模型,让毫末实现了数据“无中生有”,获得海量corner case(长尾场景)不再是难事。面对“完全从真实数据中积累的corner case困难且昂贵”的行业难题,毫末将爆火的三维重建NeRF技术应用在自动驾驶场景重建和数据生成中,它通过改变视角、光照、纹理材质的方法,生成高真实感数据,实现以低成本获取normal case,生成各种高成本corner case。3D重建大模型生成的数据,不仅比传统的人工显式建模再渲染纹理的方法效果更好、成本更低,增加NeRF生成的数据后,还可将感知的错误率降低30%以上。

第三,多模态互监督大模型,能够精准识别异形障碍物,让车辆“火眼金睛”。在成功实现车道线和常见障碍物的精准检测后,针对城市多种异形障碍物的稳定检测问题,毫末正在思考和探索更加通用的解决方案。多模态互监督大模型引入了激光雷达作为视觉监督信号,直接使用视频数据来推理场景的通用结构表达。通用结构的检测,可以很好地补充已有的语义障碍物检测,有效提升自动驾驶系统在城市复杂工况下的通过率。

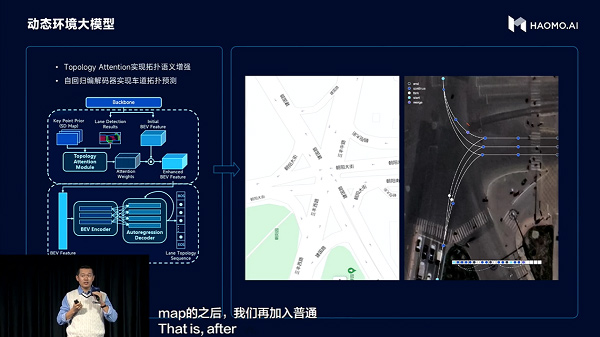

第四,动态环境大模型,可以精准预测道路的拓扑关系,让车辆始终行驶在正确的车道中。在重感知技术路线下,毫末为了将对高精地图的依赖度降到最低,面临着“道路拓扑结构实时推断”的挑战。为此,毫末在BEV(鸟瞰图)的feature map(特征图)基础上,以标精地图作为引导信息,使用自回归编解码网络,将BEV特征,解码为结构化的拓扑点序列,实现车道拓扑预测,让毫末的感知能力,能像人类一样在标准地图的导航提示下就可以实现对道路拓扑结构的实时推断。毫末认为,解决了路口问题实际就解决了大部分城市NOH问题,目前在保定、北京,毫末对于85%的路口拓扑推断准确率高达95%。即便是非常复杂、非常不规则的路口,毫末也能准确预测。

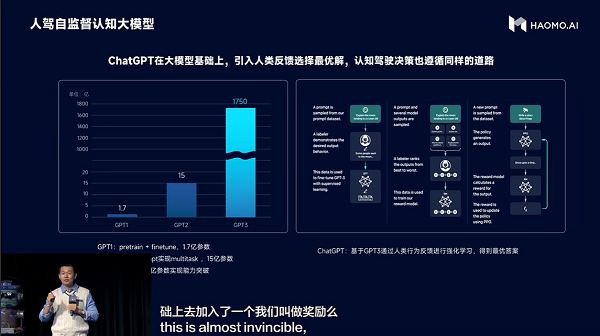

第五,人驾自监督认知大模型,掌握高水平司机的开车技法,让驾驶决策更聪明。在探索“使用大量人驾数据,直接训练模型做出拟人化决策”方面,毫末为了让模型能够学习到高水平司机的优秀开车方法,全新引入了用户真实的接管数据,同时用RLHF(从人类反馈中强化学习)思路先训练一个reward model(奖励模型)来挑选出更好的驾驶决策。通过这种方式,使毫末在掉头、环岛等公认的困难场景中,通过率提升30%以上。这与AGI领域爆火的ChatGPT的思路相同,通过人类行为反馈来选出最优答案。

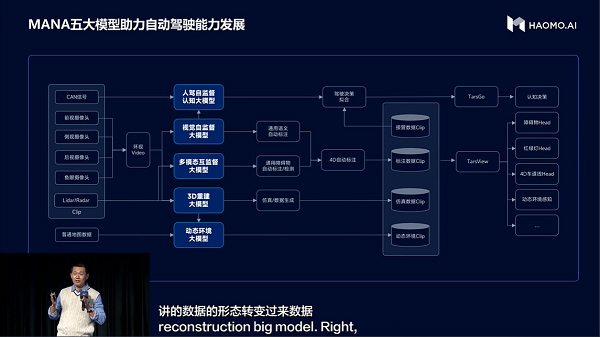

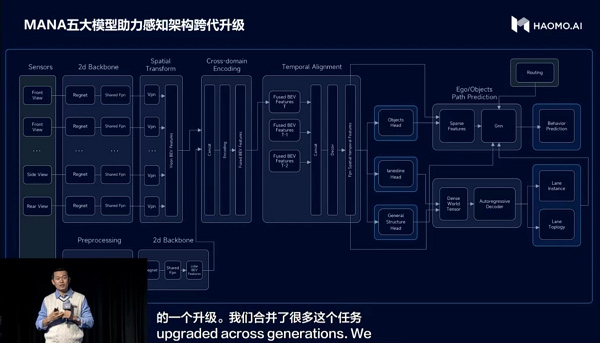

MANA五大模型全面提升了毫末感知和认知层面系统化的底层技术能力。“在五大模型助力下,MANA最新的车端感知架构,从过去分散的多个下游任务集成到了一起,形成一个更加端到端的架构,包括通用障碍物识别、局部路网、行为预测等任务,毫末车端感知架构实现了跨代升级。”顾维灏表示,这也意味着毫末的感知能力更强,产品力更强,产品可以通过快速迭代向全无人驾驶加速迈进。

随着毫末智算中心MANA OASIS的落地,数据智能体系MANA也实现了脱胎换骨的升级。在未来的日子里,不断进化的MANA作为毫末产品迭代的核心动力,将持续助力毫末发挥核心技术优势,早日实现毫末“让机器智能移动,给生活更多美好”的最新美好愿景。